| ИВМ СО РАН | Поиск |

| Отчеты ИВМ СО РАН |

Отчет ИВМ СО РАН за 2012 год

Проекты СО РАН

- Программа сибирского отделения РАН «Телекоммуникационные и мультимедийные ресурсы СО РАН»

- Программа сибирского отделения РАН «Высокопроизводительные вычисления СО РАН»

- Междисциплинарные интеграционные проекты

- Проекты СО РАН, выполняемые совместно со сторонними научными организациями

- Экспедиционные проекты СО РАН

Программа сибирского отделения РАН «Высокопроизводительные вычисления СО РАН»

Программа сибирского отделения РАН «Высокопроизводительные вычисления СО РАН»

Координатор программы: академик РАН Б. Г. Михайленко

Руководитель от КНЦ СО РАН: член-корреспондент РАН В. В. Шайдуров

Ответственный исполнитель от ИВМ СО РАН: к.т.н. С. В. Исаев

Исполнители: Д. Д. Кононов, А. В. Малышев

Проводились работы по технической поддержке и обеспечению доступа пользователей к вычислительным ресурсам. Отлажен механизм общего доступа к гибридной вычислительной системе на основе GPU. Выполнялись работы по установке и обновлению программного обеспечения, по техническому обслуживанию и администрированию используемых в Институте вычислительных кластеров с телекоммуникационным доступом.

В 2012 году ИВМ СО РАН за счет средств программы «Высокопроизводительные вычисления СО РАН» приобрел два вычислительных модуля (рис. V.2). После ввода в эксплуатацию этих вычислительных модулей в составе кластера ИВМ общее количество вычислительных ядер кластера составляет 274, его пиковая производительность увеличилась в 2.3 раза и составляет 2.04 Тфлопс с производительностью по Linpack 1.51 Тфлопс.

Рис. V.2. Четырехпроцессорный 64-х ядерный вычислительный модуль (586 Гфлопс)

В этом году началось активное использование приобретенного в 2011 году высокопроизводительного вычислительного сервера Flagman на базе графических процессоров Tesla C2050, имеющего 2 шестиядерных процессора Intel Xeon X5670 и 8 GPU nVidia Tesla C2050. Пиковая производительность этого сервера при использовании графических вычислителей составляет 8.24 Тфлопс при операциях с одинарной точностью и 4.12 Тфлопс при операциях с двойной точностью. В текущем году на этот вычислительный сервер и на имеющиеся рабочие станции с графическими вычислителями было установлено специализированное программное обеспечение MathWorks: MATLAB, Simulink и Parallel Computing Toolbox.

Для рационального использования вычислительных модулей высокой плотности была запущена дополнительная пользовательская очередь для вычислительных задач, требующих до 48 вычислительных ядер. Обеспечено резервное копирование данных вычислительного кластера ИВМ СО РАН на приобретенное сетевое хранилище, что увеличило надежность существующей системы хранения данных кластера.

На всех вычислительных кластерах с телекоммуникационным доступом ведется статистика использования ресурсов и организован телекоммуникационный доступ из сетей общего пользования. Средняя загрузка кластеров составляет около 42%. Из общего объема более 73% загрузки дают задачи пользователей Института физики СО РАН, 15% — Институт вычислительного моделирования СО РАН, 11% — Институт химии и химической технологии СО РАН.

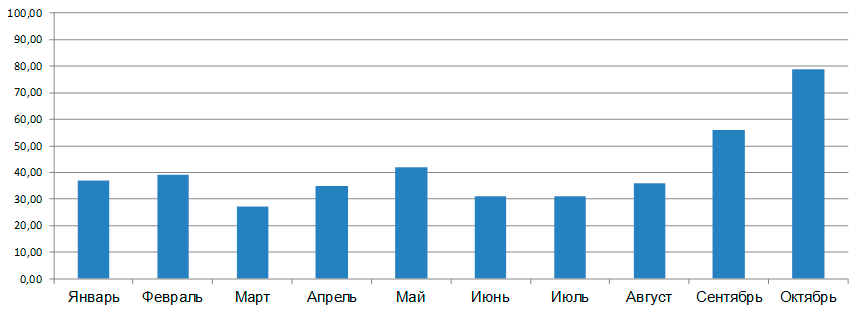

Средняя загрузка кластера в отдельные месяцы превышает 80% (рис. V.3). Снижение загрузки кластера объясняется использованием свободных вычислительных ресурсов на более мощных вычислительных системах в других научных центрах Новосибирска, Томска и Москвы, а также кластера Сибирского федерального университета.

Рис. V.3. Загрузка кластера МВС1000/146

| ФИО | Запусков задач | Организация | Вклад в загрузку (%) |

|---|---|---|---|

| Молекулярная динамика | 1326 | ИФ СО РАН | 73 |

| Алгебраические задачи | 66 | ИВМ СО РАН | 12.7 |

| Молекулярная динамика | 1280 | ИХХТ СО РАН | 11.1 |

| Гидродинамика | 52 | ИВМ СО РАН | 1.2 |

| Прочее | 3433 | ИВМ,СибГТУ и др. | 2 |

| ВСЕГО | 6157 | 100 |

Таблица V.1. Статистика использования МВС-1000/146 для расчетов (топ-лист)

Исходя из статистики видно, что в 2012 году на кластере большую долю составляют небольшие по длительности задачи — более 50% запусков дали в загрузку всего 2 процента. Это свидетельствует об увеличении числа отладочных запусков, после чего пользователи основные вычисления проводят на более мощных доступных вычислительных кластерах.

(Отделы Вычислительной математики, Вычислительной механики деформируемых сред, Прикладной информатики, Служба средств телекоммуникаций и вычислительной техники)

| К началу | |